标题 2

这里是内容。

标题 3

这里是内容。

2022年1月12日小于 1 分钟

more 注释之前的内容被视为文章摘要。

注意力机制是一个宽泛的概念(抽象表达),Q、K、V相互计算的过程就是注意力,但没有规定Q、K、V怎么来的。

例如,Self-Attention的Q、K、V来源于同一个输入矩阵X。

Cross-Attention的Q,K,V来源不同的矩阵。

注意力机制(attention是人工神经网络中一种模仿认知注意力的技术。这种机制可以增强神经网络输入数据中某些部分的权重,同时减弱其他部分的权重,以此将网络的关注点聚焦于数据中最重要的一小部分。

本文章的内容和知识为作者学习期间总结,可能存在一定错误与误区,期待各位读者指正。

本文章中的部分例子仅用于生动解释相关概念,切勿结合实际过度解读。

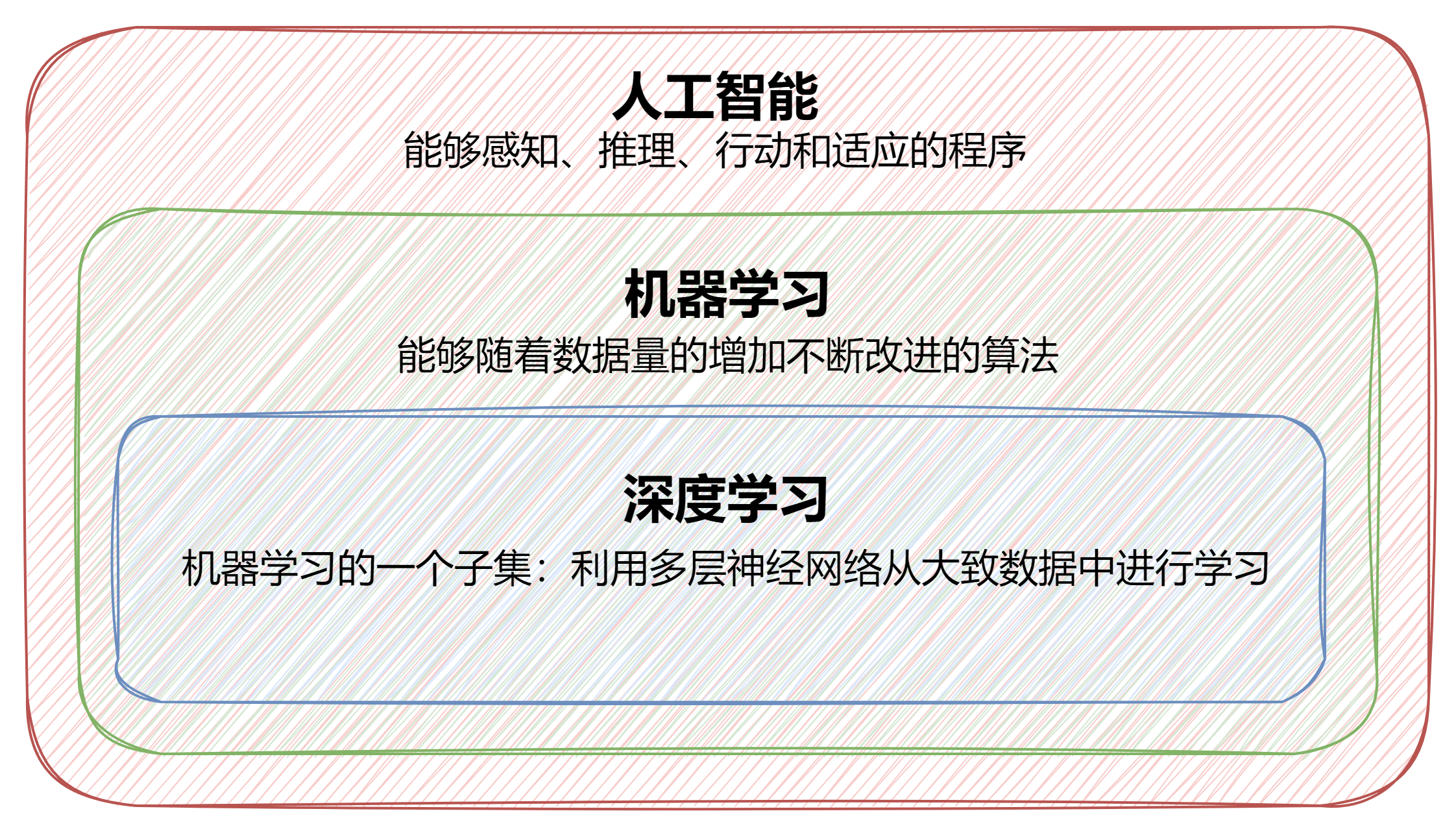

人工智能、机器学习、深度学习它们之间好像经常同时出现,其实它们是一种包含的关系。

本文章的内容和知识为作者学习期间总结且部分内容借助AI理解,可能存在一定错误与误区,期待各位读者指正。

本文章中的部分例子仅用于生动解释相关概念,切勿结合实际过度解读。

语雀链接:《神经网络概述》

部分内容来源:B站:李哥考研

本章内容已经更新完成,如有不足之处,不妨评论区一叙